协方差与得分函数:从Fisher信息矩阵看统计关联

协方差(Covariance)是统计学中一个基础但强大的概念,它描述了两个随机变量之间的关系。在Fisher信息矩阵中,协方差以一种特别的形式出现:得分函数的协方差。你可能注意到它的定义 ( I ( θ ) i j = E [ s i s j ] I(\theta)_{ij} = E\left[ s_i s_j \right] I(θ)ij=E[sisj] )(其中 ( s i = ∂ log p ( x ∣ θ ) ∂ θ i s_i = \frac{\partial \log p(x|\theta)}{\partial \theta_i} si=∂θi∂logp(x∣θ) ))似乎“少了均值”,这是怎么回事?今天我们就从这个角度出发,聊聊协方差的本质、得分函数的特殊性,以及它们在实际中的应用。

什么是协方差?

协方差衡量两个随机变量 (

X

X

X ) 和 (

Y

Y

Y ) 如何一起变化,定义为:

Cov

(

X

,

Y

)

=

E

[

(

X

−

E

[

X

]

)

(

Y

−

E

[

Y

]

)

]

\text{Cov}(X, Y) = E[(X - E[X])(Y - E[Y])]

Cov(X,Y)=E[(X−E[X])(Y−E[Y])]

展开后:

Cov ( X , Y ) = E [ X Y ] − E [ X ] E [ Y ] \text{Cov}(X, Y) = E[XY] - E[X]E[Y] Cov(X,Y)=E[XY]−E[X]E[Y]

- 如果协方差为正,( X X X ) 增加时 ( Y Y Y ) 也倾向于增加。

- 如果为负,则一个增加另一个减少。

- 如果为零,说明两者在统计上“无关”(但不一定是完全独立的)。

通俗比喻

想象你在观察天气:( X X X ) 是温度,( Y Y Y ) 是降雨量。协方差告诉你,当温度升高时,降雨量是更可能增加(正协方差,像夏天多雨),还是减少(负协方差,像沙漠地区),或者没啥关系(零协方差)。

得分函数与Fisher信息矩阵

在Fisher信息矩阵中,协方差以得分函数的形式出现。得分函数是対数似然函数对参数的偏导数:

s i = ∂ log p ( x ∣ θ ) ∂ θ i , s j = ∂ log p ( x ∣ θ ) ∂ θ j s_i = \frac{\partial \log p(x|\theta)}{\partial \theta_i}, \quad s_j = \frac{\partial \log p(x|\theta)}{\partial \theta_j} si=∂θi∂logp(x∣θ),sj=∂θj∂logp(x∣θ)

Fisher信息矩阵的元素定义为:

I ( θ ) i j = E [ s i s j ∣ θ ] I(\theta)_{ij} = E\left[ s_i s_j \bigg| \theta \right] I(θ)ij=E[sisj θ]

这被描述为“得分函数的协方差”,反映了参数 ( θ i \theta_i θi ) 和 ( θ j \theta_j θj ) 变化时似然波动的关联性。

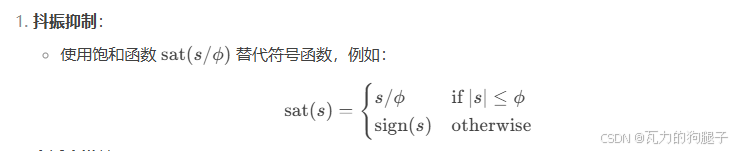

为什么“少了均值”?

你可能会疑惑:普通的协方差定义是 ( E [ X Y ] − E [ X ] E [ Y ] E[XY] - E[X]E[Y] E[XY]−E[X]E[Y] ),而这里只有 ( E [ s i s j ] E[s_i s_j] E[sisj] ),似乎少了 ( − E [ s i ] E [ s j ] -E[s_i]E[s_j] −E[si]E[sj] ) 这一项。这是定义错误,还是有意为之?

答案在于得分函数的一个关键性质:它的期望为零。即:

E [ s i ∣ θ ] = E [ ∂ log p ( x ∣ θ ) ∂ θ i ∣ θ ] = 0 E[s_i | \theta] = E\left[ \frac{\partial \log p(x|\theta)}{\partial \theta_i} \bigg| \theta \right] = 0 E[si∣θ]=E[∂θi∂logp(x∣θ) θ]=0

为什么期望为零?

证明很简单:

E [ s i ] = ∫ ∂ log p ( x ∣ θ ) ∂ θ i p ( x ∣ θ ) d x = ∫ 1 p ∂ p ∂ θ i p d x = ∫ ∂ p ∂ θ i d x E[s_i] = \int \frac{\partial \log p(x|\theta)}{\partial \theta_i} p(x|\theta) \, dx = \int \frac{1}{p} \frac{\partial p}{\partial \theta_i} p \, dx = \int \frac{\partial p}{\partial \theta_i} \, dx E[si]=∫∂θi∂logp(x∣θ)p(x∣θ)dx=∫p1∂θi∂ppdx=∫∂θi∂pdx

因为 ( p ( x ∣ θ ) p(x|\theta) p(x∣θ) ) 是概率密度,总积分恒为1:

∂ ∂ θ i ∫ p ( x ∣ θ ) d x = ∫ ∂ p ∂ θ i d x = 0 \frac{\partial}{\partial \theta_i} \int p(x|\theta) \, dx = \int \frac{\partial p}{\partial \theta_i} \, dx = 0 ∂θi∂∫p(x∣θ)dx=∫∂θi∂pdx=0

在正则条件下(积分和导数可交换),( E [ s i ] = 0 E[s_i] = 0 E[si]=0 )。同样,( E [ s j ] = 0 E[s_j] = 0 E[sj]=0 )。

回到协方差

既然 ( E [ s i ] = 0 E[s_i] = 0 E[si]=0 ),( E [ s j ] = 0 E[s_j] = 0 E[sj]=0 ):

Cov ( s i , s j ) = E [ ( s i − E [ s i ] ) ( s j − E [ s j ] ) ] = E [ s i s j ] − E [ s i ] E [ s j ] = E [ s i s j ] − 0 ⋅ 0 = E [ s i s j ] \text{Cov}(s_i, s_j) = E[(s_i - E[s_i])(s_j - E[s_j])] = E[s_i s_j] - E[s_i]E[s_j] = E[s_i s_j] - 0 \cdot 0 = E[s_i s_j] Cov(si,sj)=E[(si−E[si])(sj−E[sj])]=E[sisj]−E[si]E[sj]=E[sisj]−0⋅0=E[sisj]

所以,( I ( θ ) i j = E [ s i s j ] I(\theta)_{ij} = E[s_i s_j] I(θ)ij=E[sisj] ) 确实就是得分函数的协方差,没有“少”任何项,只是因为均值为零,协方差简化为期望积的形式。

得分函数协方差的意义

在Fisher信息矩阵中,( I ( θ ) i j I(\theta)_{ij} I(θ)ij ) 作为得分函数的协方差,有什么特别含义呢?

- 对角元素(如 ( I i i I_{ii} Iii )):是 ( s i s_i si ) 的方差,衡量单个参数 ( θ i \theta_i θi ) 变化时似然波动的强度。值越大,数据对 ( θ i \theta_i θi ) 越敏感。

- 非对角元素(如 ( I i j , i ≠ j I_{ij}, i \neq j Iij,i=j )):是 ( s i s_i si ) 和 ( s j s_j sj ) 的协方差,反映 ( θ i \theta_i θi ) 和 ( θ j \theta_j θj ) 之间的信息关联。如果 ( I i j = 0 I_{ij} = 0 Iij=0 ),说明两者“正交”,调整一个参数不影响另一个。

例如,在正态分布 ( N ( μ , σ 2 ) N(\mu, \sigma^2) N(μ,σ2) ) 中:

- ( I μ σ 2 = E [ x − μ σ 2 ⋅ ( − 1 2 σ 2 + ( x − μ ) 2 2 ( σ 2 ) 2 ) ] = 0 I_{\mu\sigma^2} = E\left[ \frac{x - \mu}{\sigma^2} \cdot \left( -\frac{1}{2\sigma^2} + \frac{(x - \mu)^2}{2(\sigma^2)^2} \right) \right] = 0 Iμσ2=E[σ2x−μ⋅(−2σ21+2(σ2)2(x−μ)2)]=0 )

- ( μ \mu μ ) 和 ( σ 2 \sigma^2 σ2 ) 正交,估计时互不干扰。

协方差的应用

协方差的概念不仅限于Fisher信息矩阵,在统计和机器学习中有广泛应用:

1. 参数估计的不确定性

Fisher信息矩阵的逆 ( I ( θ ) − 1 I(\theta)^{-1} I(θ)−1 ) 给出了最大似然估计(MLE)的协方差矩阵近似:

Cov ( θ ^ ) ≈ I ( θ ) − 1 \text{Cov}(\hat{\theta}) \approx I(\theta)^{-1} Cov(θ^)≈I(θ)−1

- 对角元素是参数估计的方差。

- 非对角元素是参数间的协方差,反映估计的耦合程度。

2. 数据分析

在数据分析中,协方差矩阵描述多个变量的关系。比如身高和体重可能有正协方差,而温度和降雨量可能有负协方差,帮助我们理解变量间的模式。

3. 主成分分析(PCA)

PCA通过协方差矩阵的特征分解,找到数据的主要变化方向,降维时保留最大方差。

4. 机器学习优化

在自然梯度下降中,Fisher信息矩阵(即得分函数的协方差矩阵)调整梯度方向。如果参数正交(非对角协方差为零),优化更高效,因为梯度方向分离。

总结

协方差是衡量变量关联性的基本工具,在Fisher信息矩阵中以得分函数的形式出现。( I ( θ ) i j = E [ s i s j ] I(\theta)_{ij} = E[s_i s_j] I(θ)ij=E[sisj] ) 之所以直接是期望积,是因为得分函数的均值为零,省去了减均值项。这种协方差不仅揭示了参数的信息含量,还在参数估计、数据分析和优化中发挥关键作用。下次看到协方差时,不妨想想:它背后的均值是不是零?这个小细节可能藏着大智慧!

后记

2025年2月24日23点13分于上海,在Grok3大模型辅助下完成。